Claude بلا إعلانات، وOpenAI تعيد ترتيب النماذج… من يربح ثقة المستخدم؟ 🚫📣 |

| 5 فبراير 2026 • بواسطة نشرة الذكاء الاصطناعي • #العدد 26 • عرض في المتصفح |

|

خميسكم سعيد يا أصدقاء 👋

|

|

|

|

أهلًا بكم في عدد جديد من نشرتكم الأسبوعية. هذا الأسبوع يمكن وصفه بأسبوع “معركة الثقة”: Anthropic تؤكد أن Claude سيبقى بلا إعلانات، بينما تعيد OpenAI ترتيب نماذج ChatGPT في خطوة تعكس أن تجربة المستخدم ونموذج العمل أصبحا جزءًا من جودة المنتج. |

|

وفي الخلفية، سباق المنصات يتسارع: NVIDIA تدفع بفكرة “المنصة المتكاملة” مع Rubin، وGoogle توسع Gemini داخل Chrome ليقترب أكثر من مفهوم الوكيل المنفذ. ومع كل هذه القفزات، يعود السؤال الأهم: كيف نبني أدوات أذكى… دون أن نفتح أبوابًا جديدة للمخاطر؟ قراءة ممتعة! |

| *** |

الأخبار العالمية |

| *** |

|

OpenAI تتجه لتقاعد عدة نماذج من ChatGPT (منها GPT‑4o) الشهر القادم |

|

أعلنت OpenAI أنها ستسحب أو تقاعد عددًا من النماذج داخل ChatGPT خلال الشهر القادم، في خطوة تُقرأ كإعادة “ترتيب رفوف” النماذج: تجربة أبسط للمستخدم، ووضوح أكبر لما هو الافتراضي وما هو المتقدم، مع ضبط التكلفة والأداء. |

|

بالنسبة للشركات، هذا تذكير بأن الاعتماد على نموذج واحد داخل منصة طرف ثالث يحتاج خطة بديلة واختبارات توافقية قبل أي تغيير مفاجئ. |

|

(المصدر: CNBC – الرابط) |

| *** |

|

NVIDIA تكشف Rubin: “منصة” وليس مجرد GPU |

|

قدمت NVIDIA تفاصيل منصة Rubin كتصميم rack‑scale يدمج GPU وCPU وشبكات وبنية تحتية ضمن نظام واحد متكامل، لأن عصر نماذج “التفكير” دائم التشغيل يضع قيودًا جديدة: طاقة، اعتمادية، أمن، وسرعة نشر. |

|

الخلاصة: المنافسة انتقلت من بيع شرائح إلى بيع “مصانع ذكاء” جاهزة للتوسع… وهذا يرفع سقف التوقعات لمن يبني مراكز بيانات أو يقدم خدمات سحابية. |

|

(المصدر: NVIDIA Technical Blog – الرابط) |

| *** |

|

رويترز: مراجعة أمن قومي تُبقي مبيعات شرائح NVIDIA المتقدمة للصين في limbo |

|

تشير تقارير إلى أن مبيعات شرائح NVIDIA المتقدمة للصين ما تزال متوقفة عمليًا بسبب مراجعة أمن قومي أمريكية. هذا النوع من الضبابية التنظيمية لا يؤثر فقط على الإيرادات، بل على خطط السعة وسلاسل التوريد وجدولة توسعات مراكز البيانات عالميًا. |

|

في عالم الذكاء الاصطناعي، السياسة أصبحت متغيرًا هندسيًا لا يمكن تجاهله. |

|

(المصدر: Reuters – الرابط) |

| *** |

|

Anthropic: Claude سيبقى بلا إعلانات |

|

أعلنت Anthropic بوضوح أنها لا تنوي إدخال الإعلانات إلى Claude، وتقدم ذلك كرسالة ثقة وتجربة استخدام. النقاش هنا أعمق من “إعلانات أو لا”: من يمول تشغيل النماذج المكلف؟ الاشتراكات؟ المؤسسات؟ أم نموذج هجين قد يخلق تضارب حوافز مع المستخدم؟ |

|

أسبوعًا بعد أسبوع، “نموذج العمل” صار جزءًا من تقييم جودة المساعد، وليس فقط جودة الإجابة. |

|

(المصدر: CNBC – الرابط) |

| *** |

|

Claude Cowork: أدوات موجهة للأعمال القانونية والامتثال |

|

تتحدث تقارير عن تحديث أو إضافة ضمن منظومة “Cowork” لدى Anthropic تركز على مهام قانونية وامتثال مثل مراجعة المستندات وتتبع الالتزامات. الرسالة: موجة الوكلاء تتحول من “مساعد عام” إلى حلول عمودية تستهدف قطاعات محددة، حيث القيمة أعلى والمخاطر أعلى أيضًا. |

|

هذا النوع من الأدوات سيضغط على البرمجيات التقليدية والساعات البشرية في الأعمال المكتبية المتخصصة. |

|

(المصدر: Business Insider – الرابط) |

| *** |

|

Gemini Drops: تحديثات Gemini + اتجاه “Personal Intelligence” |

|

نشرت Google “Gemini Drops” كتحديثات شهرية لتطبيق Gemini، مع تركيز على مزايا تجعل المساعد أكثر “شخصنة” عبر ربطه بمنظومة تطبيقات Google. الفكرة التي تتكرر: نموذج قوي وحده لا يكفي، القيمة تأتي عندما يصبح المساعد جزءًا من سير عملك اليومي وبياناتك (مع أسئلة واضحة حول الخصوصية والاختيار). |

|

(المصدر: Google – الرابط) |

| *** |

- YouTube |

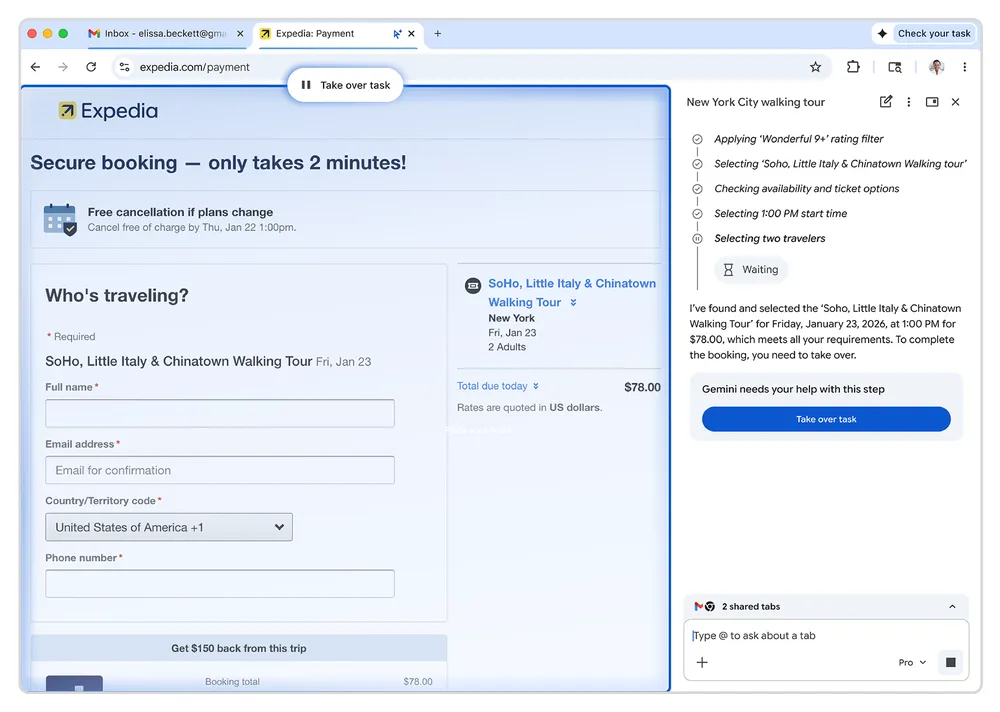

Gemini داخل Chrome: لوحة جانبية + Auto‑browse |

|

توسع Google تجربة Gemini داخل Chrome عبر لوحة جانبية وميزات agentic مثل Auto‑browse، تجعل المتصفح نفسه “ينفذ” المهام بدل أن يكتفي بالإجابة. لكن كل خطوة نحو التنفيذ تعني: صلاحيات أكثر، ومخاطر أكثر، وحاجة أكبر للشفافية (ماذا فعل؟ ماذا ضغط؟ ماذا أرسل؟). |

| *** |

|

أمن الوكلاء: prompt‑injection وتسريبات بيانات ومفاتيح… الخطر يكبر مع “الاستقلالية” |

|

أعادت تقارير أمنية هذا الأسبوع تسليط الضوء على تهديدات الوكلاء: هجمات prompt‑injection، قواعد بيانات مكشوفة، وتسريب رموز وصول ومفاتيح. الدرس العملي: الوكيل = حساب ذو صلاحيات. لا بد من أقل صلاحية، وعزل الأدوات، ومراجعة السجلات، وعدم تخزين أي أسرار في ذاكرة طويلة الأمد بلا حوكمة. |

|

(المصادر: SecurityWeek – Wiz – The Hacker News) |

| *** |

الأخبار المحلية |

| *** |

|

السواحة: “منظمة التعاون الرقمي” دعمت نشوء 16 شركة مليارية |

|

تصريحات تبرز أثر العمل الإقليمي والدولي على نمو شركات تقنية كبيرة، وتعيد التركيز على بناء بيئة تمكينية للشركات، وليس استيراد الحلول فقط. |

|

(المصدر: الخليج 24 – الرابط) |

| *** |

- YouTube |

وثيقة “مبادئ الذكاء الاصطناعي في الإعلام” بالشراكة مع سدايا |

|

إعلان وثيقة مبادئ للاستخدام المسؤول للذكاء الاصطناعي في قطاع الإعلام والمحتوى، وهي خطوة مهمة في لحظة تتسارع فيها أدوات التوليد والتزييف العميق. |

| *** |

|

السواحة: “الثقة + التقنية + المواهب” ركائز مستقبل رقمي شامل |

|

زاوية تؤكد أن السباق ليس على الأدوات فقط: بل على بناء الثقة (حوكمة وأمان)، وتمكين التقنية، وتطوير المواهب، وهي الثلاثية التي تحدد من يبتكر ومن يستهلك. |

|

(المصدر: عكاظ – الرابط) |

| *** |

تقنيات الأسبوع |

| *** |

|

Gemini داخل Chrome (Side Panel + Auto‑browse) |

|

المتصفح يتحول إلى مساحة عمل “مساعد” بدل مجرد نوافذ، اتجاه مرشح لتغيير سلوك المستخدمين بسرعة. |

|

(المصدر: Google – الرابط) |

| *** |

|

PostToolUse Defender (حماية ضد Indirect Prompt Injection) |

|

أداة دفاعية مهمة مع تصاعد الوكلاء: حماية ما بعد استخدام الأدوات، حيث قد تُزرع تعليمات خبيثة داخل محتوى خارجي. |

|

(المصدر: Lasso – الرابط) |

| *** |

|

CAI: وكيل Pentesting يربط LLM بأدوات مثل Nmap وBurp |

|

يوضح اتجاه “AI للأمن” بشكل عملي: من جمع النتائج إلى تفسيرها ثم اقتراح خطوات لاحقة في مسار واحد. |

|

(المصدر: Help Net Security – الرابط) |

| *** |

ركن التعلم |

| *** |

|

كورس: Quality and Safety for LLM Applications |

|

كورس عملي يركز على تقييم الجودة والسلامة والتعامل مع مخاطر مثل prompt injection في تطبيقات LLM. |

|

(المصدر: DeepLearning.AI – الرابط) |

| *** |

|

مرجع: OWASP LLM01 — Prompt Injection |

|

مرجع سريع لبناء قائمة مخاطر وضوابط، خصوصًا للفرق التي تبني وكلاء أو تربط أدوات خارجية. |

|

(المصدر: OWASP GenAI – الرابط) |

| *** |

|

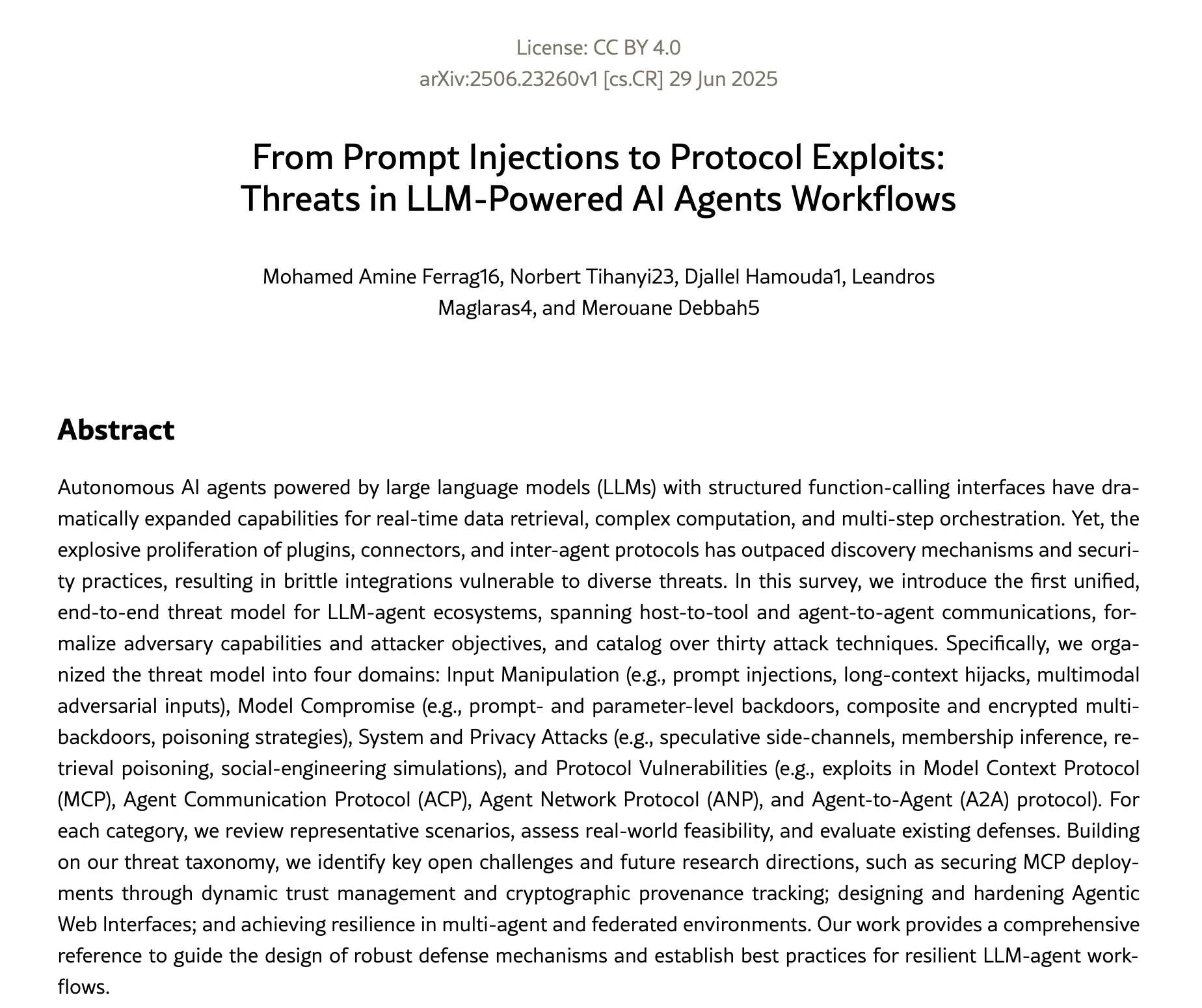

ورقة: Threats in LLM‑powered AI agents workflows |

|

قراءة أعمق لتصنيف تهديدات الوكلاء من “حقن” إلى “استغلال بروتوكولات”، مناسبة لمن يريد بناء دفاعات منهجية. |

|

(المصدر: arXiv – الرابط) |

| *** |

برومبت الأسبوع (Prompt of the Week) |

| *** |

|

Claim Checker (مدقق الادعاءات) |

|

Prompt (English):“Analyze the text below and extract: (1) verifiable claims (facts, numbers, names, dates), (2) opinions/predictions, and (3) ambiguous or missing details.Then produce a concise verification table with columns: Claim → How to verify → Two credible sources to check → Confidence (1–5).Text: [paste the text]” |

|

يحوّل أي خبر/مقال إلى قائمة ادعاءات قابلة للتحقق مع طريقة التحقق ومصادر مقترحة، لتقليل مشاركة معلومات غير دقيقة. |

|

النسخة العربية: |

|

"حلّل النص أدناه واستخرج: (1) ادعاءات قابلة للتحقق (حقائق، أرقام، أسماء، تواريخ)، (2) آراء أو توقعات، و(3) نقاط غامضة أو معلومات ناقصة.ثم أنشئ جدول تحقق مختصر بالأعمدة التالية: الادعاء → كيف أتحقق؟ → مصدران موثوقان للتحقق → درجة الثقة (1–5).النص: [الصق النص]" |

| *** |

Learn It Fast (حوّل الخبر إلى خطة تعلم في أسبوع) |

|

Prompt (English):“Create a 7-day learning plan to understand and apply: [Topic/Tool].For each day include: (1) a clear goal, (2) a hands-on task, (3) a tangible output (artifact), and (4) a short self-quiz (3 questions).Also include 5 curated resources, split into beginner and advanced.Topic/Tool: [enter here]” |

|

يحوّل أي تقنية أو خبر إلى خطة تعلم قصيرة بمهام يومية ومخرجات واضحة، بدل القراءة العامة بدون تطبيق. |

|

النسخة العربية: |

|

"أنشئ خطة تعلم لمدة 7 أيام لفهم وتطبيق: [موضوع/أداة].لكل يوم اذكر: (1) هدفًا واضحًا، (2) مهمة تطبيقية، (3) مخرجًا ملموسًا (Artifact)، و(4) اختبارًا ذاتيًا قصيرًا (3 أسئلة).وأضف 5 مصادر منتقاة مقسمة إلى مبتدئ ومتقدم.الموضوع/الأداة: [اكتبها هنا]" |

| *** |

AI Policy Draft (مسودة سياسة استخدام الذكاء الاصطناعي للشركات) |

|

Prompt (English):“Draft an internal AI usage policy for a [company type/industry].It must include: data classification (public/internal/confidential), what employees are allowed to paste into public AI tools, rules for agentic AI (permissions, approvals, audit logs), secret management (API keys), and pre-publication review requirements (Legal/PR/Security).Provide two versions: (1) a short 10-bullet policy, and (2) a detailed ~2-page policy.Company context: [paste context]” |

|

يطلع لك مسودة سياسة داخلية جاهزة تغطي أهم نقاط الحوكمة والخصوصية والأمان، خصوصًا مع استخدام الوكلاء وأدوات الذكاء الاصطناعي العامة. |

|

النسخة العربية: |

|

"اكتب مسودة سياسة داخلية لاستخدام الذكاء الاصطناعي داخل شركة [نوع الشركة/القطاع].يجب أن تشمل: تصنيف البيانات (عام/داخلي/سري)، ما المسموح لصقه في أدوات الذكاء الاصطناعي العامة، قواعد استخدام الوكلاء (الصلاحيات/الموافقات/سجلات التدقيق)، إدارة الأسرار (مفاتيح API)، ومتطلبات المراجعة قبل النشر (قانوني/علاقات عامة/أمن).أعطني نسختين: (1) نسخة مختصرة من 10 بنود، و(2) نسخة موسعة بطول يقارب صفحتين.سياق الشركة: [الصق السياق هنا]" |

| *** |

|

بهذا نصل لختام عدد هذا الأسبوع. إذا أعجبتك النشرة، مررها لشخص مهتم، وارسل لنا أي خبر يستحق “تفكيك” أعمق الأسبوع الجاي؟ |

نشرة الذكاء الاصطناعي البريدية

كل أسبوع نأخذك في جولة سريعة بين أحدث الابتكارات، أبرز الأخبار، وأذكى التطبيقات التي ترسم ملامح الغد. نقدم لك المعلومة جاهزة، موثوقة، ومختصرة، لتبقى دائمًا في مقدمة من يفهمون ويواكبون ثورة الذكاء الاصطناعي.

المزيد من نشرة الذكاء الاصطناعي البريدية

26 فبراير 2026

19 فبراير 2026

التعليقات